Black Hat SEO & White Hat SEO

Copyright @ Shutterstock / chaiyapruek youprasert

Das Black Hat SEO bedient sich im Gegensatz zum White Hat SEO “verbotener” Methoden und missachtet bzw. verletzt bewusst die Suchmaschinen-Richtlinien.

Inhaltsverzeichnis

1. Was versteht man unter Black Hat SEO und White Hat SEO?

Die Bezeichnung Black Hat und White Hat bezieht sich auf die Cowboys in alten Western-Filmen. Das typische Duell: Der gute Cowboy trägt den weißen, der Böse trägt den schwarzen Hut. Die Bezeichnung kann aber auch auf den “schwarzen Magier” oder “Mafiosi” zurückgeführt werden.

Im Bezug auf Suchmaschinenoptimierung (SEO) beschreibt es die Methode mit der man SEO betreibt. Dies beeinflusst stark das Ergebnis und den langfristigen Erfolg. Im Allgemeinen wird zwischen zwei Arbeitsweisen unterschieden: Black und White Hat SEO, die strikt voneinander zu trennen sind. Das Black Hat SEO bedient sich im Gegensatz zum White Hat SEO “verbotenen” Methoden und missachtet bzw. verletzt bewusst die Suchmaschinen-Richtlinien. In den meisten Fällen handelt es sich um massives Spamming. Beispielsweise werden die Mitbewerber aggressiv und durch manipulative Maßnahmen aus den Suchergebnissen verdrängt, damit man deren hohe Positionen für sich selbst ergattert. Durch Black Hat SEO werden höchstens rasche und meist nur kurzlebige SEO-“Erfolge” erreicht. Aus langfristiger Sicht jedoch, schadet Black-Hat SEO nur.

Da die Suchmaschinen solche Vorgehensweisen massiv bekämpfen, sollte man Black Hat Maßnahmen unbedingt vermeiden.

Wenn Black Hat SEO aufgedeckt wird, muss der Verursacher mit Abmahnungen der Suchmaschine und schlechteren Rankings rechnen. Im schlimmsten Fall wird die Website vollständig aus den Suchergebnissen ausgeschlossen. Und dann ist es sehr schwierig das Vertrauen der Suchmaschine zurückzugewinnen. Es sollten also alle Details der Optimierung gut überlegt sein und die Suchmaschinen-Richtlinien auf jeden Fall beachtet werden. Dies ist unabdingbar um langfristig ein gutes und stabiles Suchmaschinen-Ranking zu erreichen.

2. Black Hat Maßnahmen

Hinweis

Achten Sie darauf, dass Sie keine dieser Methoden auf Ihrer Website anwenden!

Mittlerweile haben sich die Suchmaschinen auf Black Hat SEO Tricks eingestellt und können die meisten aufdecken. So verlieren Sie ganz schnell Ihr Ranking oder werden komplett von der Suchmaschine ignoriert.

Achten Sie darauf, dass Ihr SEO Anbieter eine legitime Beratungsfirma ist. Sie sollte den Fluss und Content Ihrer Website verbessern und keinesfalls irreführende Taktiken verwenden oder versuchen die Suchmaschinen zu täuschen. Sorgen Sie dafür, dass Ihre Domain mit keinem trügerischen Dienst in Verbindung gebracht wird, sonst könnte sie aus dem Suchmaschinenindex verbannt werden.

3. White Hat SEO

Im Gegenteil zum Black Hat SEO zählt beim White Hat SEO die Ehrlichkeit und der Verzicht auf Trickserei und Manipulation. Es handelt sich um eine fundierte und erlaubte Optimierung, die langfristige Ranking-Erfolge anvisiert. Wir bei der Online Solutions Group GmbH optimieren die Webseiten unserer Kunden auf natürliche Art und Weise und halten uns streng an Suchmaschinen-Richtlinien.

3.1 OnPage-Optimierung

Die OnPage-Optimierung ist der erste Schritt bei der Suchmaschinenoptimierung. Dazu gehören unter anderem die hierarchisch saubere URL-Struktur mit sinnvoller Benennung von Ordnern und Seiten sowie die interne Verlinkung.

Suchmaschinen versuchen beispielsweise schon anhand der URL-Struktur zu erkennen, wie die Site hierarchisch und inhaltlich gegliedert ist. In der Regel ist ein Website-Aufbau ab einer bestimmten Größe in einzelne Übersichtsseiten (Ressort-Homepages) unterteilt unter denen dann z.B. Artikel-Detailseiten thematisch geordnet sind. Dies erleichtert sowohl dem Besucher, als auch dem Suchmaschinen-Crawler die Orientierung. In der URL-Struktur sollte dies auch entsprechend abgebildet sein, indem z.B. die Übersichtsseite direkt über einen URL-Pfad als dessen Homepage aufgerufen werden kann (z.B. www.meinedomain.de/ressort1/) und die darunter liegenden Artikel-Detailseiten (wie in einem Verzeichnisbaum auf der Festplatte) alle in diesem Pfad als Seiten mit der Endung .html liegen. Bei einer derartigen Struktur erhält jede Detailseite gemäß ihrer Bedeutung von den Suchanbietern eine individuelle Gewichtung.

Da die Suchmaschine erkennen kann, dass alle Unterseiten dieses Ressorts zu der übergeordneten Übersichtsseite gehören, addiert sie die individuellen Rankings zusammen “nach oben” auf die Übersichtsseite. Im Endeffekt läuft das darauf hinaus, dass eine Übersichtsseite, die in ihrem “Pfad” viele gute Unterseiten hat, einen besseren Page-Rank erhält, als eine mit nur sehr wenigen Unterseiten. Bei vielen Websites liegen aber Übersichtsseiten und Detailseiten hierarchisch nebeneinander auf der gleichen Ebene. In diesem Fall kann die Suchmaschine oft keine Rankings aggregieren, was ein deutlicher Nachteil ist.

Tipp

Wertvolle Informationen und aktuelle Trends aus dem Bereich SEO erhalten Sie auch beim OSG Solutions Day. Jetzt kostenlos anmelden!

3.2 Interne Verlinkungen

Auch die Anzahl und Qualität der internen Verlinkung spielt bei White Hat SEO eine große Rolle: für den Besucher nützliche und jeweils passende interne Querverweise werden auch von den Suchmaschinen positiv bewertet. Außerdem erhöht eine gute interne Verlinkung die Erreichbarkeit und Eindringtiefe sowohl seitens der Besucher als auch der Suchmaschinen.

Bei White Hat SEO wird weiterhin die Einhaltung des (X)HTML- und anderer Web-Standards, wie CSS, beachtet und die Zusammensetzung des Codes und Content-Textes analysiert. Dieser kann z.B. durch CSS-Positionierung im Quelltext weit oben eingegliedert werden, wodurch Suchmaschinen ihn höher gewichten. Sehr wichtig sind hierbei Codebestandteile wie z.B. der Seitentitel, die Hauptüberschrift (<h1>) sowie nachfolgende Überschriften (<h2>, <h3> usw.). Hier muss klar das Thema der Seite erkennbar sein.

Alle relevanten Bereiche eines Internetauftritts sollten erreichbar und für die Suchmaschine indizierbar sein. Links von und zu der Seite sollten darüber hinaus auf keinen Fall per JavaScript eingebaut sein, sondern als Standard-HTML-Tags. JavaScript wird nämlich von den Suchmaschinen weitestgehend ignoriert.

Außerdem sollte wichtiger Content, Namen und Links nicht in Bilder integriert werden. Der Google-Crawler kann keinen in Grafiken enthaltenen Text erkennen. Dieser sollte entweder mit regulärem HTML formatiert werden oder mit alt-Tags umschrieben werden. Alt-Tags sind

HTML-Attribute, die für Bilder und Grafiken im IMG-Tag definiert werden können.

3.3 OffPage-Optimierung

Zusätzlich sollte die Webseite themenrelevant sein und von den richtigen, zum Thema passenden Webseiten verlinkt werden. Diesen Themenbereich der externen Link-Struktur nennt man OffPage-Optimierung. Es bringt nicht sehr viel, von themenfremden Seiten verlinkt zu werden. Wenn Sie beispielsweise eine Site zu einem Spezialthema haben, bringt ihnen ein Link einer verwandten Website, die größer und bekannter, aber allgemeiner ist, besonders viel. Linkpartner sollten außerdem stets ein positives Bild auf die eigene Seite werfen. Eine “Bad Neighbourhood” (“schlechte Nachbarschaft”) sollte unbedingt vermieden werden. Dazu gehören Seiten, bei denen ein erheblicher Verstoß gegen die Suchmaschinen-Richtlinien (z.B. massives Spamming) nachgewiesen wurde. Die Linkstruktur sollte ausgeglichen sein. Einige Links mit geringerem Pagerank und ein paar Links mit hohem Pagerank. Gut wäre es wenn Links von Null bis 10 vertreten sind. Ein hoher Pagerank hat natürlich eine sehr positive Wirkung auf die Website.

Zudem ist relevant, wie und worauf gelinkt wird. Direkte Verweise auf die Unterseiten mit dem entsprechenden Thema sind besser als Verlinkungen auf die Startseite der Domain. Das wirkt natürlicher und wird höher gewichtet. Genauso ist der Text der verlinkten Seite von großer Relevanz, er sollte mit der verlinkten Seite weitgehend übereinstimmen.

Weitere Links kann man bei der Off-Page Optimierung durch verschiedene Artikelverzeichnisse generieren. Beispielsweise die klassischen und redaktionell betreuten Verzeichnis-Dienste wie Yahoo!, Web.de und DMOZ. Diese nehmen nur Links in ihre Datenbank auf, die von Menschen geprüft wurden. Es gibt auch Artikelverzeichnisse, die als Gegenleistung für einen Fach- oder Erlebnis-Artikel vom Autor festzulegende themenrelevante Links anbieten. Das Schreiben von exklusiven Texten eigens für das Artikelportal ist allerdings ein recht zeitaufwändiger Prozess.

Zum kostenlosen Backlink Checker der OSG

3.4 Maßnahmen gegen die Black Hats

Link-Spamming:

Eine technische Möglichkeit um gegen Link-Spam vorzugehen, ist das so genannte nofollow-Attribut. Dieses kann einfach in den HTML-Link-Tag eingebaut werden:

In Suchmaschinen erscheinen diese Links dann nicht als “Vote” bzw. “Empfehlung” für die verlinkte Seite. Finden die Suchmaschinen-Crawler solche “nofollow”-Attribute in den Verlinkungen vor, wissen sie, dass sie dem Link nicht folgen dürfen (nofollow = nicht folgen). Die verlinkte Webseite wird dadurch für die Suchmaschine uninteressant und das Spamming unwirksam.

4 Darauf sollten Sie besonders achten

4.1 Geben Sie den Nutzern die gesuchten, hochwertigen Informationen

Bieten Sie auf Ihrer Website nur qualitativen und übersichtlich gegliederten Content, von der Startseite bis zu den Unterseiten. Beschreiben Sie Ihren Inhalt klar und eindeutig und verwenden Sie die Keywords in Ihren Texten (Begriffe, die die Nutzer eingeben würden, um Ihre Website zu suchen). Mit nützlichen Informationen können Sie zum einen Besucher gewinnen und zum anderen werden Webmaster Links zu Ihrer Website aufbauen.

4.2 Sorgen Sie dafür, dass andere Websites auf Ihre Website verlinken

Durch Links von anderen Seiten ist Ihre Website für Crawler besser auffindbar und somit in den Suchergebnissen präsenter. Ein Votum ist ein Link von Seite A zu Seite B. Votes von Seiten, die selbst “wichtig” sind, haben aber mehr Gewicht und tragen dazu bei, andere Webseiten “wichtig” zu machen.

Das Suchergebnis wird ermittelt durch die Einstufung der Wichtigkeit (dem Seitenrang) der Websites sowie durch ausgefeilte Mechanismen zum Textvergleich. So können Seiten angezeigt werden, die sowohl wichtig als auch relevant für die jeweilige Suche sind.

Hinweis

Die Algorithmen von Google können “natürliche” von “künstlichen” Links unterscheiden. Künstliche Links sind also langfristig nicht nützlich. Nur natürliche Links, die dynamisch aus dem Web hervorgehen, sind relevant für die Indizierung und das Ranking Ihrer Website. Dabei bewerten andere Webmaster den Content Ihrer Website als wertvoll und möglicherweise nützlich für die eigenen User.

4.3 Achten Sie darauf, dass jeder Nutzer ohne Probleme auf Ihre Website zugreifen kann

Bauen Sie auf Ihrer Website eine logische Link-Struktur auf, jede Seite sollte man über mindestens einen statischen Textlink erreichen können.

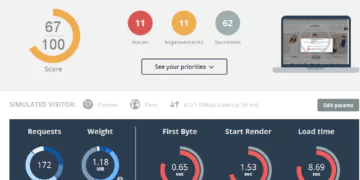

Um Ihre Website zu überprüfen, verwenden Sie einen Textbrowser wie Lynx, da die meisten Spider die Websites so sehen. Jetzt können Sie kontrollieren, ob Funktionen wie JavaScript, Cookies, Session-IDs, Frames, DHTML oder Flash verhindern, dass Ihre Website in einem Textbrowser angezeigt werden kann. Dies kann das Crawling der Website durch Spider verhindern. Achten Sie also auf die korrekte Darstellung, auch in Lynx.

Wenn Sie vermuten, dass Ihre dynamischen Website-URLs (z.B. www.meinedomain.de/?id=123&session=7890 den Webcrawlern Probleme bereiten könnten, erstellen Sie statische Kopien dieser Seiten. Der Google-Index beinhaltet zwar dynamische Seiten, diese machen aber nur einen kleinen Teil des Indexes aus.

Denken Sie aber daran, beim Erstellen dieser statischen Kopien, Ihre dynamischen Seiten zu Ihrer robots.txt-Datei hinzuzufügen. Sonst könnten Suchmaschinen diese als Duplikate behandeln.

5. Suchmaschinen-Richtlinien

Um nicht aus dem Suchmaschinen-Index ausgeschlossen zu werden, sollten Sie sich strikt an die Suchmaschinen-Richtlinien halten. Besonders die sogenannten Qualitätsrichtlinien sollten nie außen vor gelassen werden. In diesen finden Sie einige illegale Praktiken, die zu Strafmaßnahmen wie der dauerhaften Entfernung aus dem Index führen können. Bei Google wird eine Website wird nach entsprechenden Strafmaßnahmen (Penalties) sowohl aus den Ergebnislisten von Google ausgeschlossen, als auch von Partner-Seiten.

Am besten Sie schenken auch den Richtlinien für Gestaltung, Content und den technische Richtlinien Beachtung, dann kann Google Ihre Website noch besser finden, indizieren und analysieren. Und Sie profitieren viel mehr von Ihrer Website.

Hier ein Google Video zu den Richtlinien:

5.1 Wie sollte man bei Penalties vorgehen?

Im SEO wird unter “Penalty” die “Bestrafung” der Website durch Suchdienste bezeichnet. Falls der Fall eintritt und Sie “abgestraft” werden oder Ihre Website sogar aus dem Suchmaschinen-Index verbannt wird, ist Ihr weiteres Vorgehen enorm wichtig. Sie dürfen sich nun keine Fehler mehr erlauben.

Automatisierte Abstrafungen durch die Suchmaschinen- Algorithmen machen sich meist dadurch bemerkbar, dass sich die Rankings der betreffenden Seiten massiv und schlagartig verschlechtern. Oder Ihre Website erscheint überhaupt nicht mehr bei Google & Co.

Um zu überprüfen, ob eine Seite aus dem Index ausgeschlossen wurde, gibt es die einfache Möglichkeit einen bestimmten Satz oder Textauszug der Seite zu kopieren und in Anführungszeichen in die Suchmaschine einzugeben. Taucht Ihre Seite nicht in den Suchergebnissen auf, ist es sehr wahrscheinlich, dass sie abgestraft wurde und sich nicht mehr im Index der Suchmaschine befindet.

5.2 Abgestraft – und nun?

Gehen Sie der Sache also sofort auf den Grund und beheben Sie die Ursachen für die Abstrafung!

Machen Sie sich Gedanken über den Anlass der Penalty. Suchmaschinen decken die meisten Verstöße früher oder später auf und Penalties erfolgen selten ohne Grund. Finden Sie heraus gegen welche Richtlinien Sie verstoßen haben.

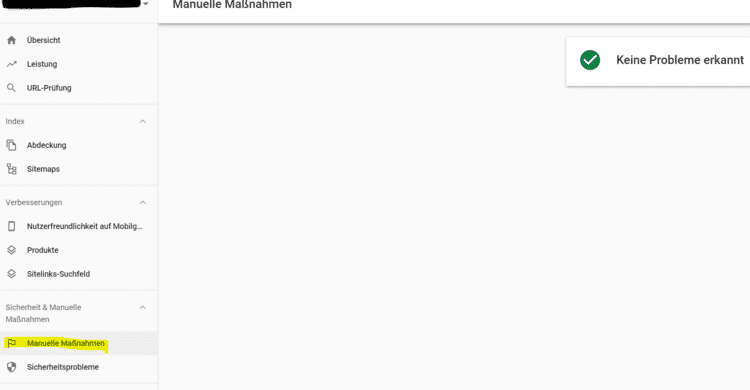

Bei Google hat man sogar den Service, dass Abstrafungen mit Hilfe des Nachrichtencenters in der Google Search Console mitgeteilt werden. So kann man schnell auf Penalties reagieren.

Dennoch sind die Gründe oft nicht sofort sichtbar, es kann zum Beispiel auch das Server Setup schuld an schlechteren Rankings sein. Wenn ein Server über die Adresse www.domain.de und über domain.de erreichbar ist und nicht auf eine einzige Schreibweise umgeleitet wird, kann dies unter Umständen zu einer Mehrfacherreichbarkeit der Seite führen.

Es empfiehlt sich zur allgemeinen Fehleranalyse, die Top Platzierungs-Seiten für einen bestimmten Suchbegriff zu überprüfen und mit seiner Website zu vergleichen.

Nachdem die Fehler behoben wurden, können Sie entweder warten oder sich aktiv an die Suchmaschinen wenden und einen “Reinclusion Request” durchführen. Bei Google können Sie diesen in der Google Search Console starten. Beim “Reinclusion Request” müssen Sie nicht komplett neu anfangen und eine neue Domain registrieren. Bei dieser weniger umfangreichen Abhilfemaßnahme verliert man die aktuellen, etablierten Domains und Besucher, eventuell auch Kunden. Davon abgesehen kostet es natürlich viel Zeit und Geld.

Fazit

Damit SEO nachhaltige Erfolge bringt, ist es notwendig sich an die Google Richtlinien zu halten. Black Hat SEO kann möglicherweise kurzfristig Erfolge in Form von verbesserten Rankings generieren, allerdings werden entsprechende Seiten später mit großer Sicherheit abgestraft, sodass alle Rankings verloren gehen. Daher sind Webmaster gut beraten, sich an de Richtlinien zu halten und von Black Hat SEO die Finger zu lassen.

Keine Kommentare vorhanden