Wichtigste SEO-Tipps im Bereich Technik 2025

Copyright © Shutterstock/ Preechar Bowonkitwanchai

Von Ladezeiten über Cloaking bis hin zum HTML-Code: Wir geben Ihnen die wichtigsten Tipps für eine SEO Technik.

Leitfaden für SEO-optimierte Entwicklung

Unsere Tipps zu den verschiedenen Optimierungsbereichen sollen Sie in die Lage versetzen, schwerwiegende SEO-Fehler bereits im Vorfeld zu erkennen und zu beseitigen. Natürlich ersetzen diese Regeln keine gründliche und nachhaltige Optimierung. Aber sie helfen dabei, das „Fundament“ auf solide Beine zu stellen.

Die OSG Performance Suite ist ein Reporting Tool, das die wichtigsten SEO Checks, die in diesem Artikel erwähnt werden, in einem Tool vereint. Dieses können Sie hier kostenfrei testen.

Technische Faktoren

Die Ladezeit, Domain und Indexierbarkeit sind wichtige SEO Faktoren, die es im technischen Bereich zu optimieren gilt.

- Die Ladezeiten Ihrer wichtigsten Seiten (Startseite und wichtige Unterseiten) sollten sich im Rahmen halten (rd. 1,5 Sekunden), da bereits geringfügig längere Ladezeiten Auswirkung auf die Bounce- und Conversion-Rate haben.

- Prüfen Sie selbst regelmäßig, wie die Ladezeiten verbessert werden können. Ein gutes Tool hierfür ist gtmetrix.com oder der Website Speed Test der OSG

- Optimieren Sie Ihre Seite auch mobil, indem Sie die Darstellung mittels Responsive Design entsprechend anpassen

Domain

- Cloaking, d.h. das Ausliefern anderer Inhalte an die Crawler der Suchmaschinen als an die Besucher (z. B. aufgrund des User-Agent oder der IP-Adresse) auf der eigenen Website ist auf alle Fälle zu verhindern, da ansonsten eine Abstrafung bis hin zur kompletten Deindexierung der Website durch Google droht. Prüfen Sie mithilfe eines geeigneten Browser-Plugins, das den Abruf als Google-Bot simuliert, ob Cloaking vorliegt.

Indexierbarkeit

- Unerreichbarkeit ist ein ernsthaftes Ranking-Problem. Zwar führt ein kurzer Ausfall nicht sofort zur kompletten Deindexierung, allerdings haben im Zuge der Initiative zur Erhöhung der Geschwindigkeit des Internets häufige und länger auftretende Ausfälle bereits spürbaren Einfluss auf die Platzierungen. Tipp: Prüfen Sie immer den Status in der Google Search Console. Google teilt Ihnen hier Verbesserungsmöglichkeiten mit. Die verantwortlichen Techniker sollten die Google Search Console regelmäßig prüfen.

Es ist somit ratsam, regelmäßig eine SEO Technik Analyse durchzuführen. Hierfür eignen sich Tools, wie der OSG SEO Check, der zu Backlinks, Domain Pop, Ladezeit und weitere, relevante Daten und Ergebnisse liefert.

Richten Sie zudem eine laufende, automatische Kontrolle für Ihre Webseite ein. Gerade nachts und am Wochenende entwickeln Shops und Websites oft ein sogenanntes “Eigenleben”, welches für 404-Fehler und höhere Ladezeiten sorgt.

Manuelle Checks vs. automatisierte Checks der Performance Suite

Manuelle SEO Technik Crawls haben viele Nachteile. Unter anderem werden Aufgaben vergessen oder technische Fehler bleiben unbemerkt.

Früher wurde alle paar Wochen oder Monate (je nach Ressourcen des SEO-Managers) ein Screaming Frog Crawl/SEO Technik Crawl gestartet. Nach Versenden der Infos an den Entwickler wurde gehofft, dass dieser die Umsetzung der nötigen Aufgaben einleitet.

Manuelle SEO Technik Crawls birgen einige Nachteile. Es ist zeitaufwendig für die Mitarbeiter, Aufgaben könnten aufgrund von Krankheit oder Urlaub vergessen werden. Durch diese Gründe bleiben technische Fehler unbemerkt, was die Performance beeinträchtigt und User bouncen. Es wird beim manuellen Prozess schnell klar, dass zu selten geprüft wird und er deshalb keinen funktionierenden Prozess darstellt.

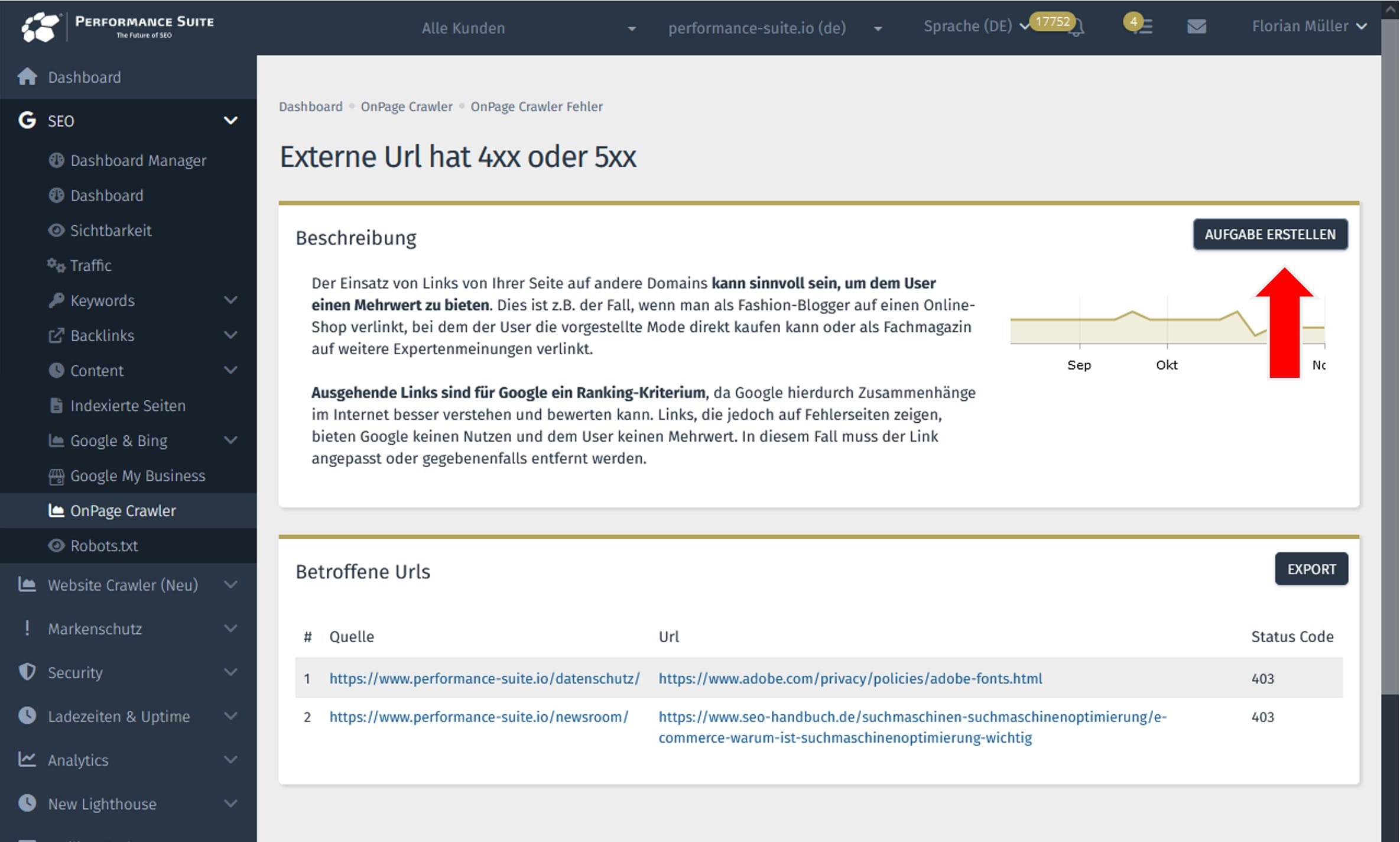

Mittlerweile gibt es den Vorteil “Tools”. Sämtliche SEO Technik Checks werden automatisch in passenden Intervallen durchgeführt. Entwickler haben den gleichen Zugang zum SEO-Tool und bei Problemen werden den betreffenden Personen Alerts zugesendet. Aus den Empfehlungen können direkt Aufgaben erstellt werden, die in der Road-Map und im Kalender erscheinen.

Im Folgenden werden Risiken beschrieben, die manuelle SEO Technik Crawls birgen.

1. Risiko: Websitegröße

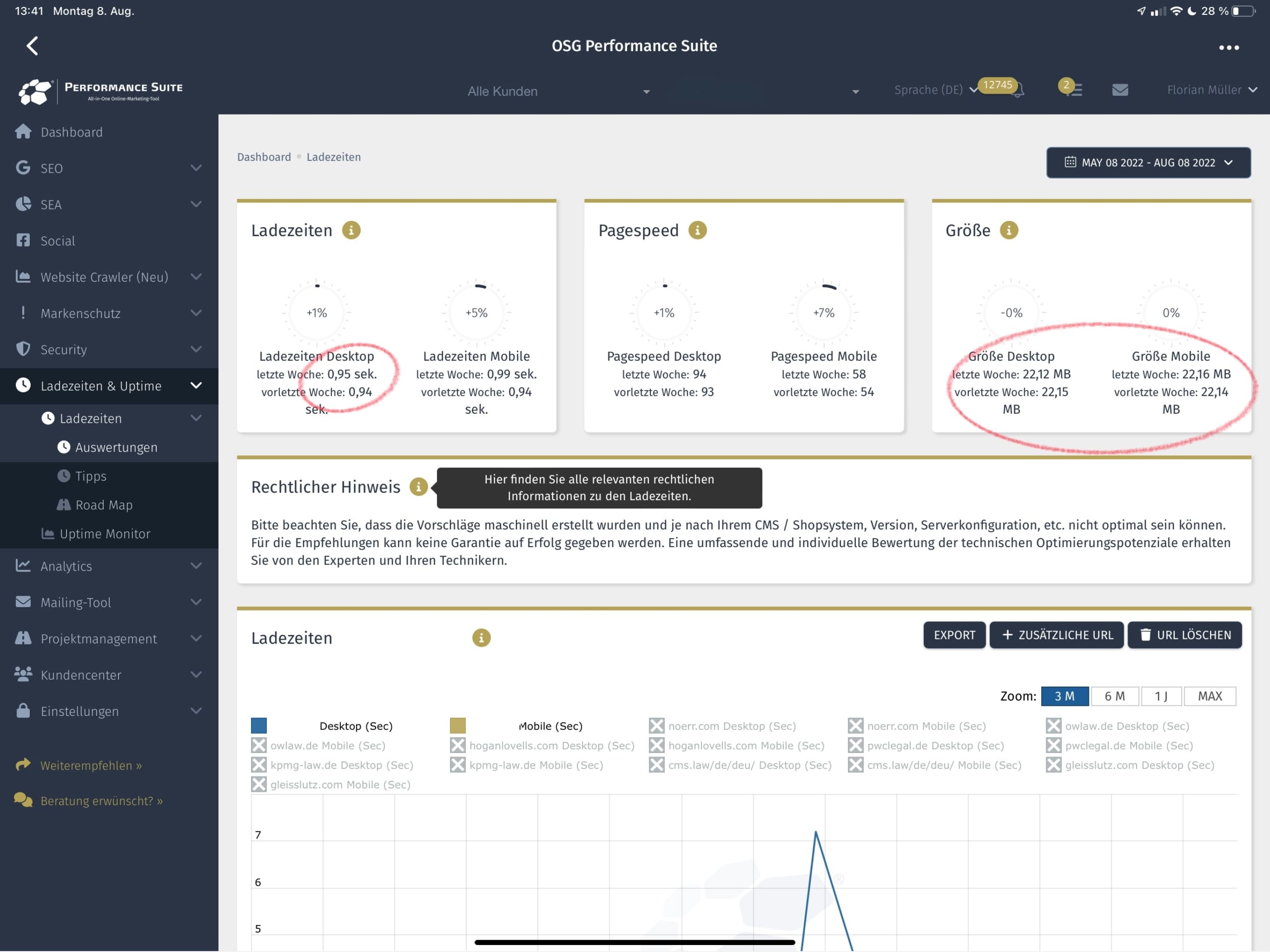

Unter anderem ist die Websitegröße ein Risikofaktor. Die folgende Firma wird von einer Typo3-Agentur und einer SEO-Agentur betreut. Intern gibt es noch einen SEO-Manager. Dennoch wurde nicht bemerkt, dass die Website 22 MB groß ist. Das ist vor allem im Hinblick auf „mobile-first“ ein Problem. Für Handynutzer ist es wichtig, kleine Seiten bereitzustellen.

Copyright © OSG | In diesem Screenshot sind Auswertungen einer älteren Lighthouse-Version zu sehen. Neue Google-Lighthouse-Versionen berechnen die mobilen Ladezeiten realistischer. Die mobilen Ladzeiten von 0,99 Sekunden ist bei 22 MB nicht zu erwarten.

2. Risiko: Technische-Fehler

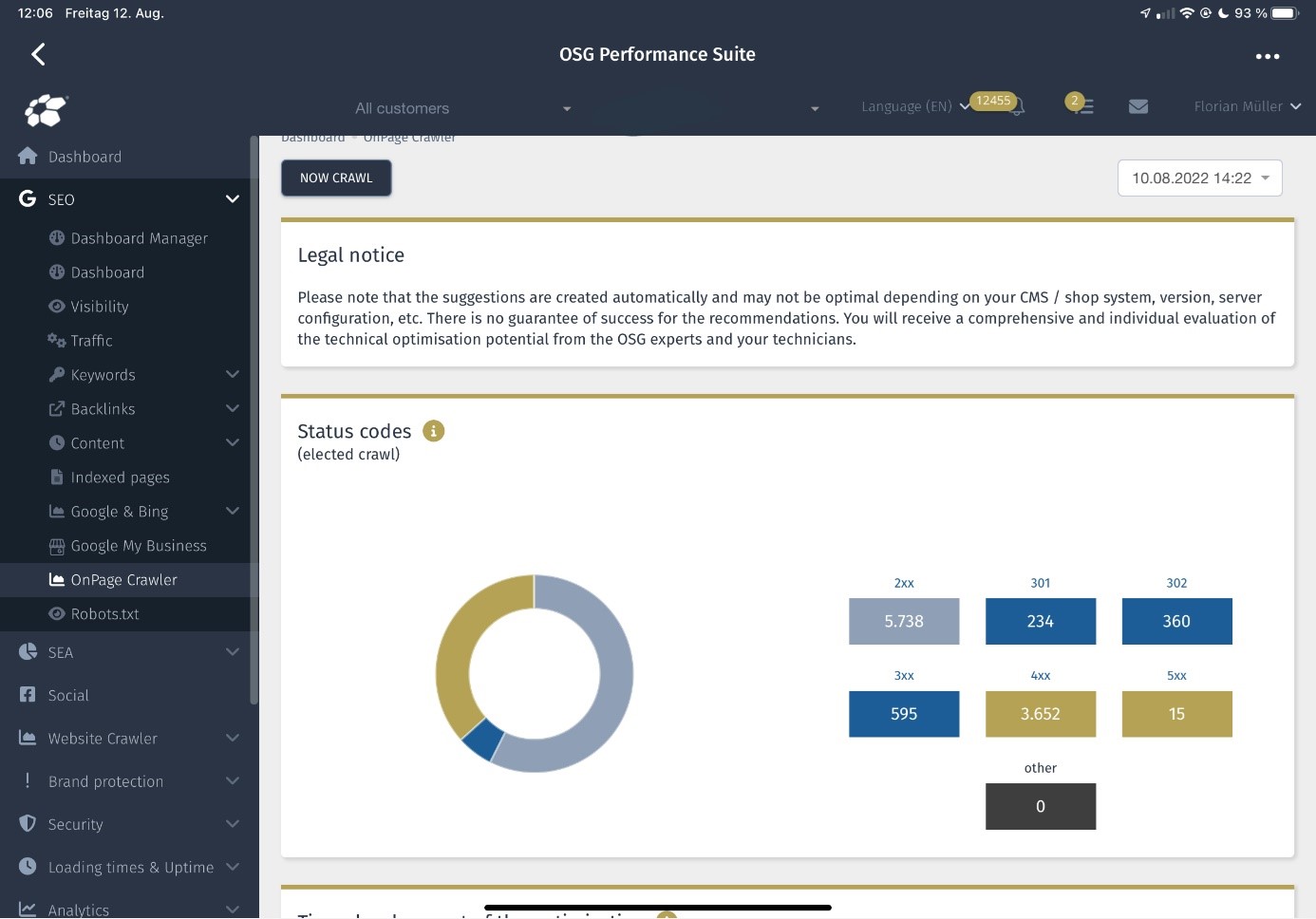

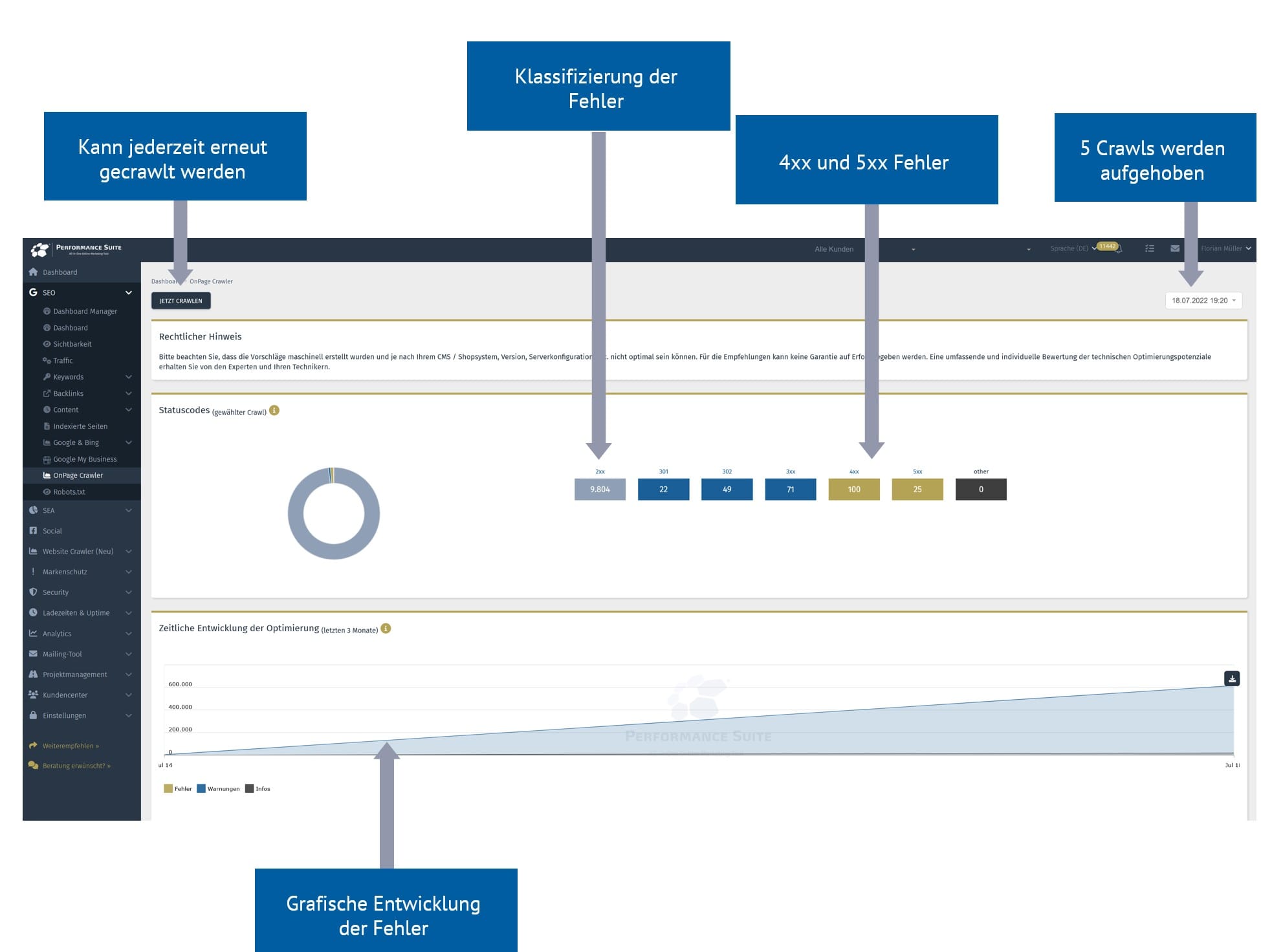

Ein weiteres großes Risiko sind Technische-Fehler, die bei manueller Überprüfung unbemerkt bleiben. Auf der folgenden Webseite wurden über 3.500 x 404-Fehler und 15 x 500-Fehler gefunden. Hier sehen Sie, dass manuell viele technische Fehler unbemerkt bleiben. Die besten Tools bringen nichts, wenn sie zu selten genutzt werden. Automatisierte Checks mit Alerts bei sehr wichtigen Problemen sind hier unerlässlich.

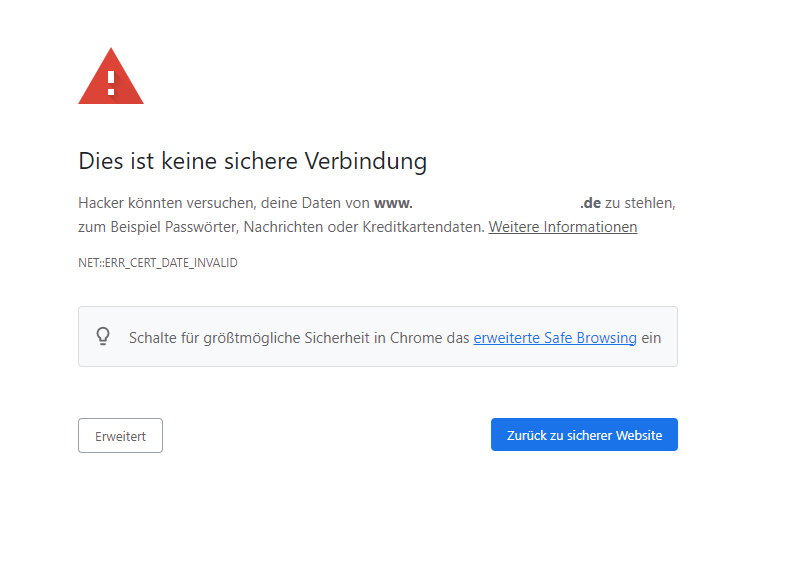

3. Risiko: Ungültiges SSL-Zertifikat

Zudem kann ein SSL-Zertifikat unbemerkt auslaufen. Dies kann sich sehr schlecht auf Ihre Performance auswirken (auch bei Media-Kampagnen z. B. Google Ads, Social, etc.). Web-Browser warnen Ihre User und diese „verlassen“ die Website.

4. Risiko: Anstieg der Ladezeiten

Durch keine regelmäßigen SEO Technik-Checks können Ladezeiten steigen, während Sie dies nicht merken. Ein plötzlicher Anstieg von Ladezeiten kann z. B. durch zu große Bilder, neues Tracking, Chat-Tool, etc. erfolgen. Auch hier leidet Ihre gesamte Performance (auch bei Media-Kampagnen z. B. Google Ads, Social, etc.).

Die Lösung, um diese Risiken zu umgehen, ist die Automatisierung von häufigen Checks. Dies übernimmt bei der OSG die Performance Suite. Die Ladezeiten werden bspw. mind. 3-4x am Tag geprüft. Die SEO Technik (z. B. 404-Fehler) wird wöchentlich geprüft. So ist stets alles unter Kontrolle. Und die Zuständigen können sich um Dinge kümmern, die nicht automatisierbar sind.

Automatisierung in der Performance Suite

| Automatisierung | Beschreibung |

| Technik | Regelmäßiger Crawl der Website/Shop auf technische Fehler. |

| Ladezeiten | Mehrfach täglich werden die Ladezeiten geprüft und in übersichtlichen Diagrammen dargestellt. |

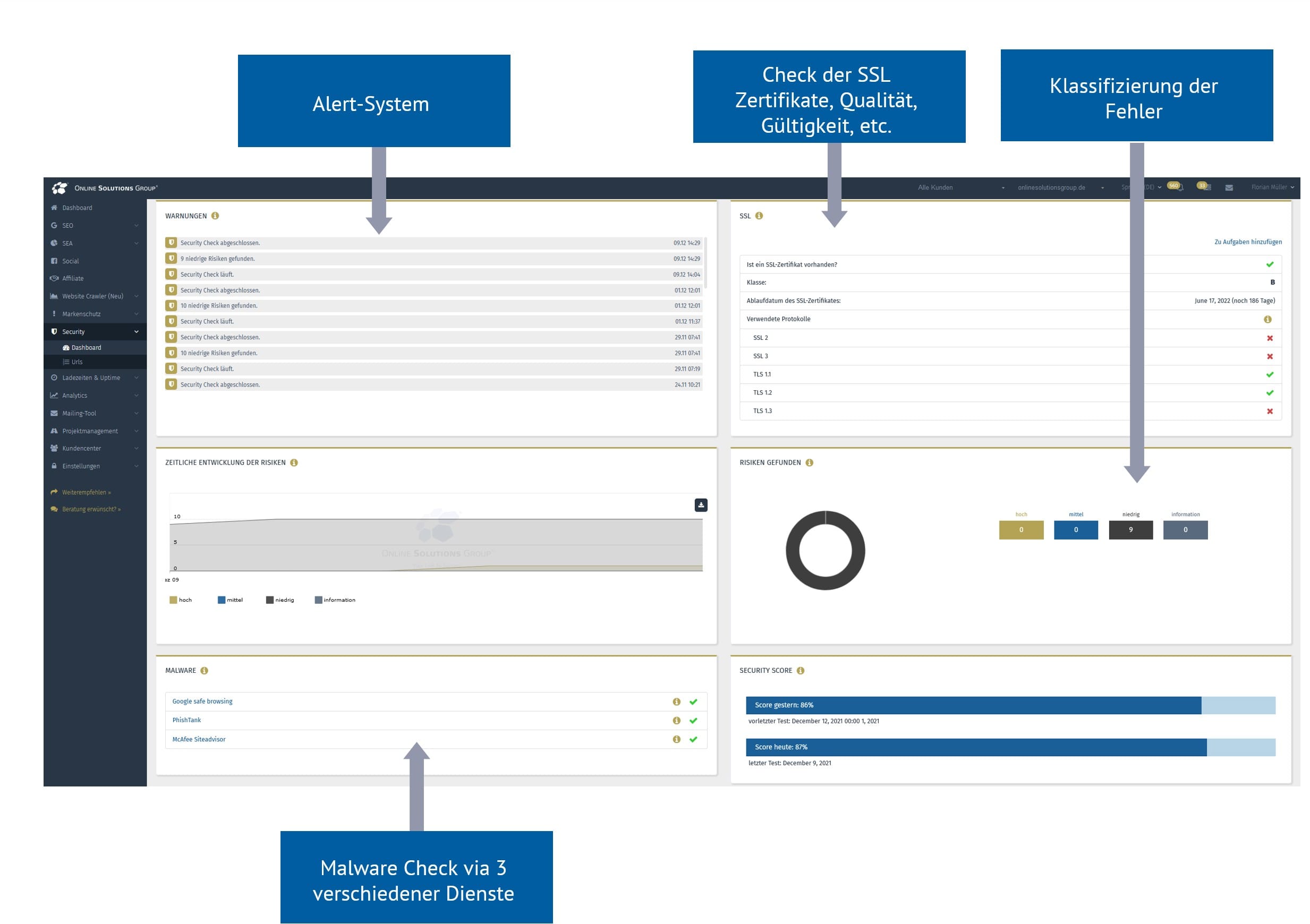

| Security | Ein Security-Crawler prüft die Website/Shop auf über 100 Security/SSL/Malware Checks. |

| Zusatz-Checks | Zahlreiche automatische Checks prüfen sämtliche Fehlerquellen, z. B. ob sich die Robots.txt geändert hat. |

| Aufgaben | Eine Aufgabenverwaltung hilft den Überblick zu behalten und macht Auswirkungen auf die Performance auswertbar. |

| Alerts | Ein Alert-System sendet Push-Nachrichten (App) und E-Mails, wenn es Probleme gibt, z. B. wenn die Ladezeiten steigen. |

- Durch die Performance Suite erfolgt eine automatische Prüfung der Website-/Shop-Technik alle 7 Tage.

- Für jeden Fehler lassen sich Aufgaben erstellen.

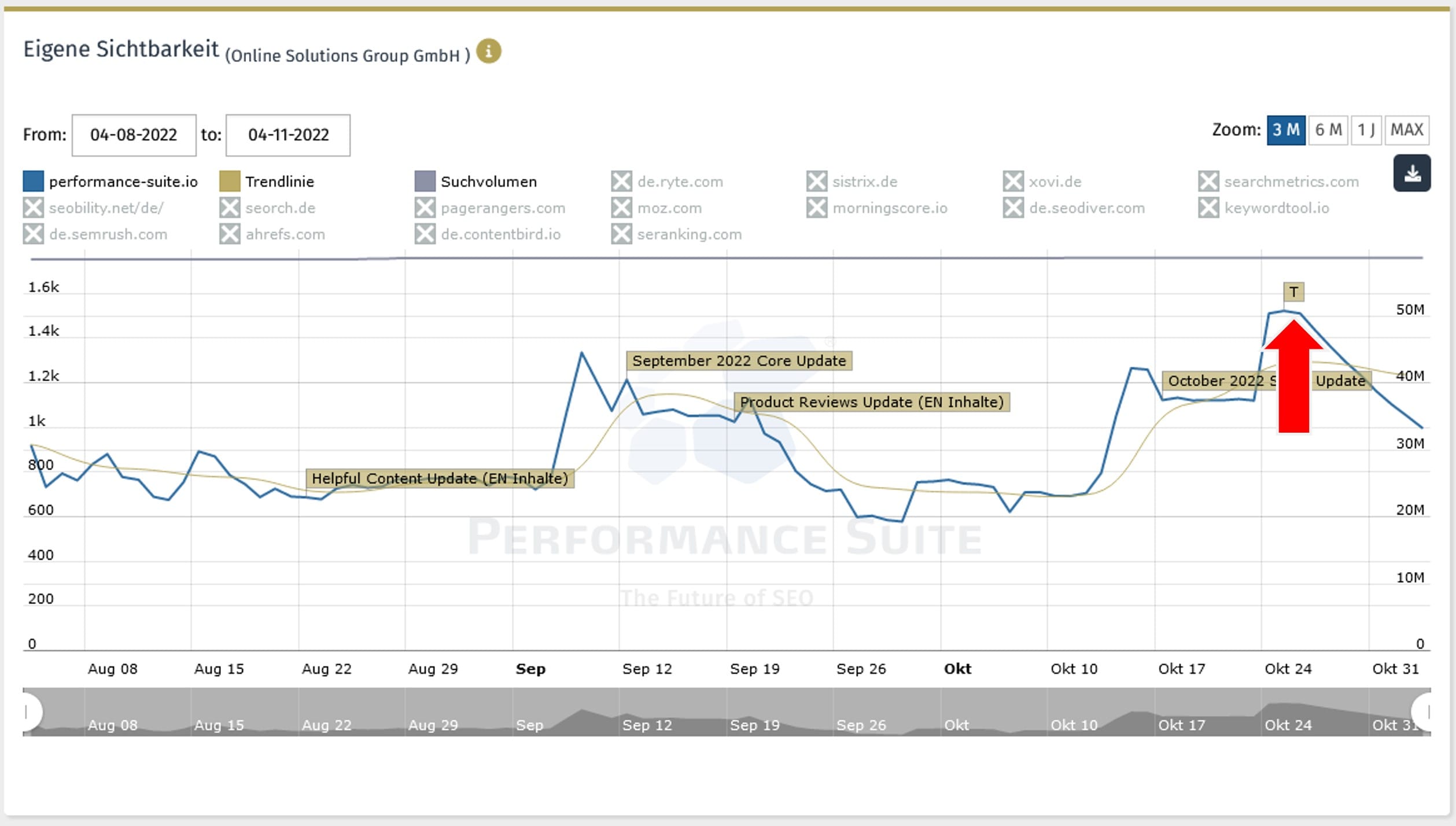

- Sobald die Aufgaben umgesetzt werden, kann der Nutzen via T-Flag in der Sichtbarkeit ausgewertet werden.

- Es werden die letzten 5 Crawls aufgehoben. So lässt sich feststellen, wann genau ein Fehler entstanden ist.

- Der Crawl läuft alle 7 Tage und kann jederzeit erneut gestartet werden.

Weitere Infos unter: https://www.performance-suite.io/seo-technik-crawler/

In der PS wird zu jedem Fehler eine Aufgabe angelegt. Diese erscheint in der Road Map und im Kalender. Es werden die Zuständigen informiert und die Aufgaben können kommentiert werden, z. B. zur Abstimmung zwischen Entwickler und SEO.

Durch das All-In-One SEO-Tool kann der Impact gemessen werden, den eine größere Änderung verursacht hat. Beispiele hierfür sind Relaunch, CMS-Update, Hoster-Wechsel, etc. Je nach Art der Aufgabe (SEO Technik, Usability, etc.) erscheint nach Umsetzung automatisch ein Flag im jeweils passenden Diagramm (Sichtbarkeit, Ladezeiten, etc.)

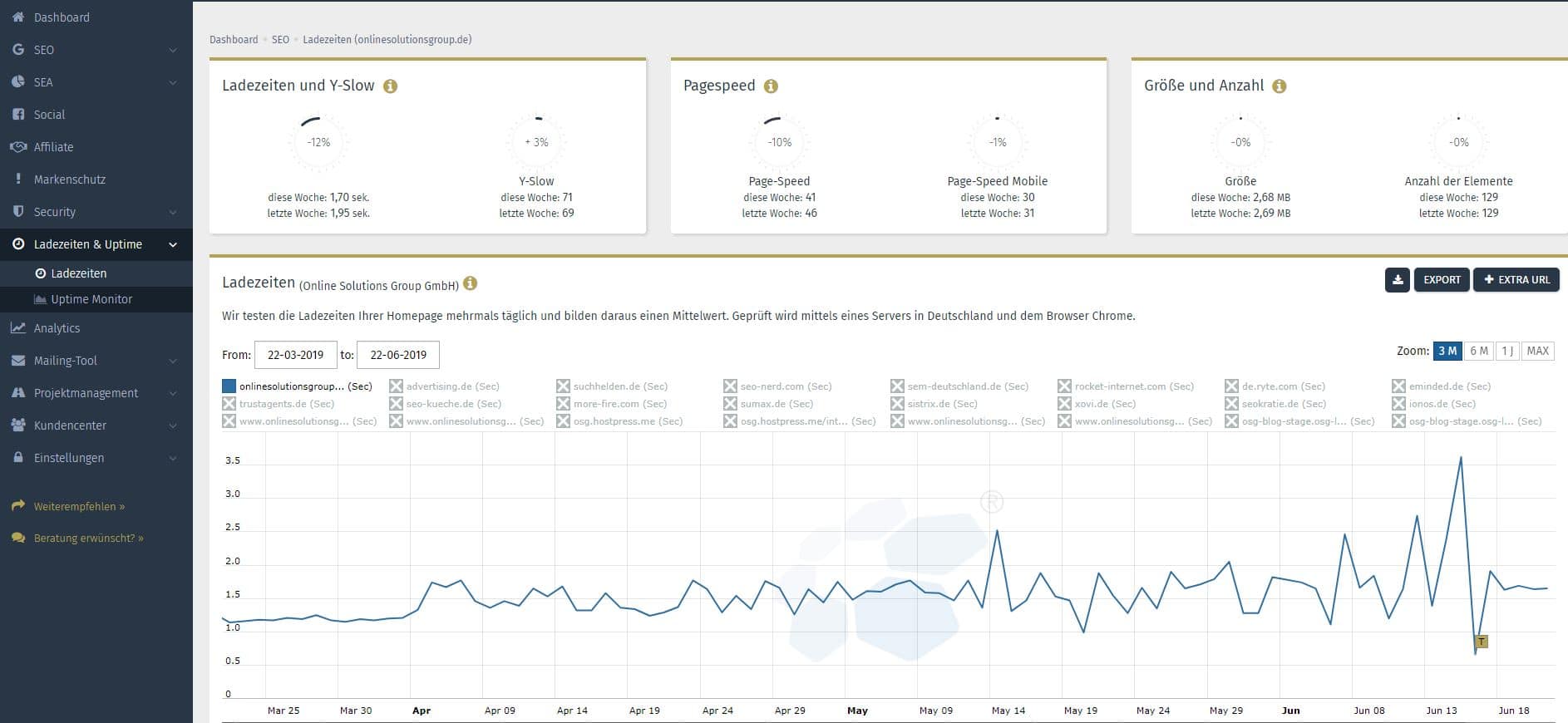

In diesem Beispiel wurde auf PHP 8 umgestellt. Zudem wurden die Ladezeiten deutlich verbessert – von ca. 1,7 auf 0,3 Sekunden (mobile Pagespeed von 27 auf 90).

Ladezeiten gehören zwar zu den offiziellen Ranking Kriterien, Rankings und Sichtbarkeit haben das hier jedoch nicht positiv beeinflusst.

Sie können sich Ihre Security Checks in Ihrem Security Dashboard anzeigen lassen. Es wird auf über 100 Security Aspekte inkl. OWASP regelmäßig und automatisch geprüft. Ihnen werden Alerts gesendet, wenn ein hohes Risiko auftritt oder Malware entdeckt wurde. Außerdem erfolgt eine automatische Überprüfung von SSL-Zertifikaten, der Uptime und, ob Malware existiert.

Weiterführende Informationen mit Cases aus der Praxis:

“Technische Fehler gibt es viele. Es ist wie einen Sack Flöhe zu hüten.” – Florian Müller | Geschäftsführer der Online Solutions Group GmbH

Weitere Infos unter: https://www.performance-suite.io/seo-technik-crawler/

Wichtige Tipps für Content Management Systeme und Shops

Bei CMS-Systemen gibt es mehrere Dinge im Bereich der Domain, URL, robots.txt und Navigation zu beachten.

Domains

- CM-Systeme produzieren nicht immer sauberen und validen Code. Prüfen Sie daher Ihren Quellcode mit folgendem Tool auf Einhaltung der W3C-Norm: validator.w3.org

- Interne Suchergebnisse gehören nicht in den Index der Suchmaschinen und sollten ausgeschlossen werden. Beispiel: www.IhreDomain.de/suche/

- Sie sollten Ihre Webseite unbedingt von http auf https umstellen, da dies eine verschlüsselte Datenübertragung gewährleistet und das Google Ranking verbessert bzw. verschlechtert, wenn die Seiten nicht umgestellt werden.

- HTML-Code sollte immer so effektiv und schlank wie möglich gestaltet sein. Skripte nach Möglichkeit in externe Dateien auslagern.

- Vergessen Sie nicht, Ihre XML-Sitemap auf einem aktuellen Stand zu halten. Gerade bei Erweiterungen der Website können Suchmaschinen die neuen Inhalte über die sitemap.xml üblicherweise deutlich schneller finden und indexieren als über den normalen Crawl-Vorgang.

- Eigene Tests haben gezeigt, dass gerade bei kleineren Projekten und Websites Seiten, die nicht in der Sitemap sind, deutlich später indexiert werden.

- Interne Verlinkungen sind für den Linkjuice genauso wichtig wie externe. Daher sollten Sie stets versuchen, Ihre Seiten stark intern zu verlinken.

- Löschen Sie alte Produktseiten nicht einfach vom Server, sondern leiten Sie diese per 301 auf die entsprechende nächsthöhere Kategorie oder auf die Startseite weiter.

- Das Canonical-Tag sollte mit äußerster Vorsicht eingesetzt werden, da bei falschem Gebrauch wichtige Seiten aus dem Index verschwinden können. Dennoch kann er sehr wichtig sein, um Duplicate Content zu vermeiden.

- Eine fundamentale Angelegenheit, die immer noch oft übersehen wird: Wenn eine Website oder wichtige Inhaltsseiten wegen falscher Verlinkung, 404-Fehlern, (unnötigerweise) passwortgeschützten Bereichen oder anderen Gründen nicht erreichbar sind, können sie auch nicht indexiert werden.

- Konfigurieren Sie Ihren Server so, dass auf Ihrem Webserver nicht existente Seiten bzw. Verzeichnisse (z. B. www.IhreDomain.de/beispiel) mit einem 404-Statuscode vom Server beantwortet werden und nicht fälschlicherweise mit einem 403-Statuscode. Sehr wichtig ist die Fehlerbehandlung bei jeder Art von Web-Applikation, da viele Systeme bei falschen oder fehlenden Parametern eigene Fehlerseiten ausgeben, die mit einem 200-ok Statuscode beantwortet und somit fälschlicherweise indexiert werden.

- Prüfen Sie regelmäßig die Google Search Console auf Broken Links (404 Fehler) und leiten Sie diese via 301 auf passende und vorhandene Seiten weiter. So verlieren Sie keine Linkpower und keine Rankings.

- Optimieren Sie zudem die Meta Daten. Diese sind Auszüge aus Ihrer Webseite, die in den Suchergebnissen angezeigt werden. Sie dienen als Vorschau für die Seite und können einen Call-to-Action enthalten.

- Auch strukturierte Daten werden immer wichtiger. Diese können als Rich Snippets, also angereicherte Suchergebnisse, in den SERPS erscheinen. Strukturierte Daten helfen der Suchmaschine die Inhalte der Website zu verstehen. Es gibt drei Möglichkeiten diese im Quellcode auszuzeichnen. Von Google werden RDFa, Mikrodaten und Mikroformate akzeptiert.

URLs

- Vermeiden Sie nach Möglichkeit dynamische URLs (URLs mit angehängten Parametern. Beispiel: www.example.com/article/bin/answer.foo?language=en&answer=3&sid=98971298178906&query=URL), da diese zu schädlichem Duplicate Content führen können.

- Es sollten daher stets sprechende URLs (SEF URLs = searchengine friendly) ausgeliefert werden z.B. www.ihreurl.de/damenschuhe/sneakers/

- Suchmaschinen bevorzugen ordentliche Strukturen innerhalb der URLs, also die Abbildung der idealerweise nach Suchbegriffen benannten Kategorien einer Website in den URLs. Auf diese Weise kann jede Seite in die logische Struktur eingebunden werden und für Suchmaschinen ergibt sich eine deutliche Zuordnung der Seiten zu den Kategorien. Beispiel: www.example.com/damenschuhe/pumps/

- Inhalte sollten immer nur unter einer einzigen URL abrufbar sein. Die Erreichbarkeit mit und ohne führendes www in der URL (domain.com und www.domain.com) führt hingegen bereits zu zwei verschiedenen URLs, unter der die gleichen Inhalte liegen. Sollte Duplicate Content nicht vermieden werden können, so ist der Einsatz des Canonical Tags zu empfehlen. Details müssen jedoch individuell für jedes Projekt ausgearbeitet werden.

- Die Indexierung von Parameter-URLs kann über die Parameterbehandlung in der Google Search Console gesteuert werden. Dies sollte aber immer nur eine Notlösung sein.

- Tracken Sie Session-IDs grundsätzlich mithilfe von Cookies und hängen Sie diese nicht an die URL an. Als Fallback-Mechanismus kann die Session-ID zwar auch als Parameter angehängt werden, aber die Seiten sollten dann unbedingt einen Canonical-Tag enthalten, der auf die URL ohne Session-IDs zeigt. Zudem sollten entsprechende Einstellungen in der Google Search Console festgelegt werden.

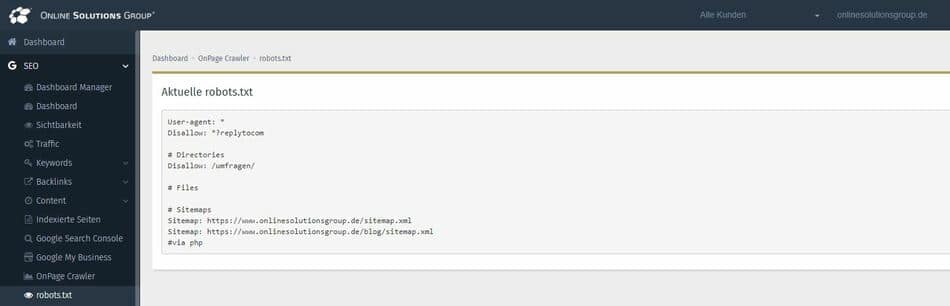

Robots.txt

- Vergessen Sie nicht, in der robots.txt-Datei einen Hinweis auf die Sitemap-XML-Datei zu geben, da Google beim Besuch einer Website zuerst die robots.txt-Datei ansieht. Beispiel für die Sitemap URL: www.website.de/sitemap.xml

- Achten Sie darauf, dass Sie in der robots.txt-Datei nicht versehentlich wichtige Unterseiten bzw. Verzeichnisse sperren.

- Die robots.txt-Datei ist eine öffentlich einsehbare Datei. Sensible Daten müssen daher anders vor einer Indexierung geschützt werden (z. B. Passwort Protection). Bedenken Sie außerdem, dass sich evtl. nicht alle Crawler an die Direktiven in der Datei halten.

- Wird eine Seite in der robots.txt-Datei gesperrt, so erscheint diese dennoch in den Suchergebnissen. Soll eine Seite nicht indiziert und nicht gecrawlt werden, ist dies über ein „noindex, follow“ Meta Tag zu lösen. Achten Sie beim lokalen Einsatz des „noindex“-Meta Tags darauf, dass durch eine fehlerhafte Programmier-Routine nicht auch andere Seiten von der Deindexierung betroffen sind!

- In der OSG Performance Suite werden Änderungen der robots.txt überwacht. Der Onpage Crawler berücksichtigt zudem robots.txt Disallow-Anweisungen.

Navigation

- Vermeiden Sie eine Navigation, die mit Hilfe von Bildern realisiert wird, da Suchmaschinen keine Bildinhalte verstehen. Aus SEO-Sicht ist eine reine Textnavigation gegenüber einer Bilder-Navigation immer vorzuziehen.

- Alle Links müssen auch sauber als Link hinterlegt sein (a href). Wer JavaScript nutzt, muss darauf achten, dass die Links auch im Quellcode und unmittelbar nach dem Laden der Seite verfügbar sind. Links, die z.B. via JavaScript erst nachgeladen werden, folgt der GoogleBot in der Regel nicht. Auch Navigationsmöglichkeiten, die auf Formular-Elementen basieren (beispielsweise DropDown-Boxen mit onChange-Händlern), können von Suchmaschinen oft nicht als Verlinkung erkannt werden. Hinter derartigen Elementen liegende Inhalte können somit komplett vor Suchmaschinen verborgen bleiben.

- Vermeiden Sie Flash komplett und verwenden Sie Flash niemals für Navigationszwecke, es sei denn, es gibt parallel eine HTML-Umsetzung.

Inhalte

- Wichtige Seitenbestandteile wie Seitentitel und Meta-Descriptions sollten immer so individuell wie möglich gestaltet werden und nicht zu lang und nicht zu kurz sein. Für den Seitentitel empfiehlt sich eine Länge zwischen 55 und 70 Zeichen, die Meta-Description sollte nicht mehr als 160 Zeichen haben.

- Perfekt wäre es, wenn Sie für jede Seite die Meta Tags individuell pflegen. Bei sehr umfangreichen Projekten können Sie z.B. standardmäßig die Überschrift als Title nutzen. Details sind für jedes Projekt individuell festzulegen. Wir empfehlen: konfigurieren Sie Ihr CMS-System so, dass Bildern ein alternativer Beschreibungstext (alt-Attribut) hinzugefügt werden kann.

- Integrieren Sie Ihre wichtigsten Keywords in den Verzeichnissen bzw. Kategorien. Zur Identifikation der wichtigsten Keywords sollten Sie das Suchvolumen ermitteln, z.B. via Google Keyword Tool oder dem OSG Keyword Planner, und die aktuelle Position berücksichtigen. Tipp: Da die Kategorien möglichst selten geändert werden sollten, empfehlen wir die Erstellung eines ordentlichen Keyword-Konzepts.

Vor- und Nachteile

Je nach Content Management System enthält dieses einige Funktionen zur SEO. Dies kann die Arbeit im SEO-Bereich vereinfachen, bringt aber auch einige Nachteile mit sich.

Relaunch

Schützen Sie Ihr Testsystem (Beispiel: dev.domain.de) vor dem Zugriff von außen durch den Einsatz eines Passwort-Schutzes, da ansonsten Duplicate Content erzeugt wird und unfertige Seiten in den Index der Suchmaschinen gelangen. Das Sperren via robots.txt empfehlen wir nicht!

- Erstens können User so trotzdem die Entwicklungsumgebung / Testumgebung einsehen.

- Die robots.txt ist eine Empfehlung für Suchmaschinencrawler, an die sich nicht alle Crawler halten.

- Häufig wird beim Übertragen der Dateien vom Testsystem auf das Live-System die robots.txt mitkopiert und so die Website komplett für Google gesperrt. Die Folge: Verlust aller Rankings und des Traffics.

Ein während der Entwicklungsphase auf dem Testsystem gesetztes „noindex“-Tag muss nach dem Relaunch unbedingt entfernt werden, da ansonsten die neuen Seiten nicht in den Suchmaschinenindex gelangen können.

Die OSG Performance Suite

- Keyword-Tool, Content Suite, Backlink Suite, SEO Technik-Crawler, Local SEO

- Künstliche Intelligenz

- SEO Reporting

- SEA-Tool inkl. SEO-SEA-Synergien

- Brand Protection

- Pagespeed-Tool & Uptime Monitoring

- Schnittstellen zu Google Ads, Google Search Console, Bing u. a.

- Projektmanagement

- inkl. App und Push Notifications

- und viele weitere Features

Sie finden den Artikel interessant?

Jetzt zum Newsletter anmelden und kostenlos mit Neuigkeiten und Online Marketing Tipps versorgt werden:

Alte URLs müssen mit einer serverseitigen 301-Weiterleitung („permanently moved“) auf die neuen URLs weitergeleitet werden und nicht fälschlicherweise mit einem 302-Redirect („temporarily moved“). Beispiel (htaccess-Datei): Redirect 301 /verzeichnis/beispiel.html www.domain.com/beispiel.html

robots.txt-Datei und XML-Sitemap müssen nach dem Relaunch unbedingt an die neue Seite und Struktur angepasst werden, um die Indexierung zu beschleunigen.

Fazit

Die Umsetzung dieser Punkte ist essentiell für jeden Webseitenbetreiber.

Mit der Ladezeitenoptimierung verbessern Sie nicht nur die Usability für die Webseitenbesucher. Sie ist zugleich auch ein positiver Ranking-Faktor. Die Indexierbarkeit der Seite wiederum ist allerdings die Grundvoraussetzung, um gefunden zu werden, weshalb sie Ihre Seite stets auf ihre Erreichbarkeit überprüfen sollten. Zudem hilft eine strukturierte Sitemap, auf die von robots.txt verwiesen werden sollte, dem Crawler Ihre Seite zu bewerten. Auch die Verwendung eines CMS-Systems, hat trotz zum Teil hoher Kosten viele Vorteile, wie die systemintegrierte Suchmaschinenoptimierung.

Die Umsetzung der oben aufgeführten Punkte trägt dazu bei, dass Ihre Webseite sich kontinuierlich verbessert und höher in den Suchergebnissen rankt. Beim Erstellen, Optimieren oder dem Relaunch einer Seite sollten diese Tipps daher gleich umgesetzt werden.

Keine Kommentare vorhanden