Facebook mit neuen Strafen für Gruppenmitglieder

Copyright © Shutterstock/Yuganov Konstantin

Facebook hat einige neue Strafen für Gruppenmitglieder angekündigt, die wiederholt gegen seine Regeln verstoßen sowie neue Kontrollmöglichkeiten für Gruppenadmins, um potenziell schädliche Inhalte in ihren Gruppen zu überwachen.

Die neuen Beschränkungen:

Facebook wird neue Reichweitenstrafen für Gruppenmitglieder einführen, deren Beiträge zuvor irgendwo auf der Plattform gegen die Facebook-Regeln verstoßen haben, und damit ihre Fähigkeit einschränken, Fehlinformationen oder Hassreden zu verbreiten.

Wie von Facebook erklärt:

“To continue limiting the reach of people who break our rules, we will start demoting all Groups content from members who have broken our Community Standards anywhere on Facebook. These demotions will get more severe as they accrue more violations.”

Dies ist von Bedeutung, da insbesondere private Gruppen ein problematisches Element bleiben, da sie keiner öffentlichen Kontrolle unterliegen. Das bedeutet, dass Menschen potenziell schädliche Inhalte unter Gleichgesinnten teilen können, die dafür offener sind, und daher weniger Strafen zu befürchten haben, während diese Änderung ihre Möglichkeiten, solche Inhalte über ihre eigenen Gruppen hinaus zu verbreiten, weiter einschränken wird, da pauschale Strafen für alle Durchsetzungsmaßnahmen eingeführt werden.

Wenn du also viel Anti-Vax-Zeug in deiner Gruppe für freie Meinungsäußerung teilst, solltest du es besser dort lassen, denn jede Strafe, die du für das Teilen desselben auf deinem persönlichen Profil erhältst, wird nun deine Möglichkeiten einschränken, dasselbe überall sonst zu verbreiten.

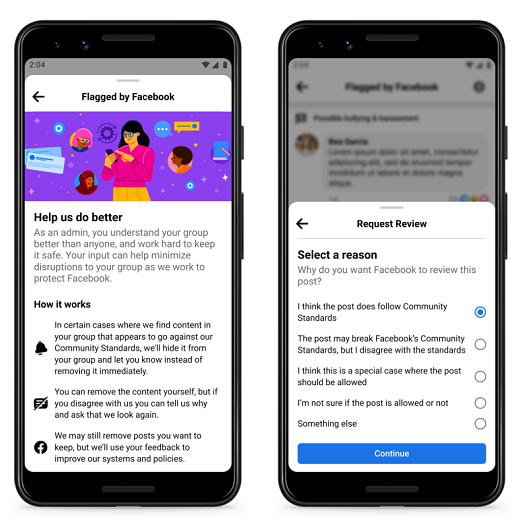

Facebook fügt außerdem ein neues Moderationselement mit der Bezeichnung “Von Facebook markiert” hinzu, das es Gruppenadministratoren ermöglicht, Inhalte zu sehen, die zur Entfernung markiert wurden, bevor sie der breiteren Gemeinschaft angezeigt werden.

Copyright © Andrew Hutchinson

Laut Facebook:

“Admins can then either review and remove the content themselves, or ask for a review by Facebook, and provide additional feedback on why they think that piece of content should remain on the platform. Flagged by Facebook involves admins in content review earlier in the process, before members receive a strike and content is removed.”

Das fügt ein zusätzliches menschliches Element hinzu – und zwar ein menschliches, das enger mit den geteilten Informationen verbunden ist, was dazu beitragen könnte, irrtümliche Löschungen zu vermeiden. Es wird auch als eine Art Bildungswerkzeug fungieren, um Administratoren zu helfen, die Arten von Beiträgen zu verstehen, die Facebook nicht zulässt, was die Gruppeninteraktion weiter verbessern und zu einer Verringerung von verletzenden Inhalten führen könnte.

Die neuen Optionen kommen zu einem Zeitpunkt, an dem Facebook nach der Enthüllung der “Facebook Files” durch das Wall Street Journal mit weiteren Fragen zu seinen Moderationsentscheidungen konfrontiert wird. Da die Beweggründe der Plattform infrage gestellt werden und neue Beweise zeigen, dass ihre Systeme erheblichen Schaden anrichten können, ist es für Facebook wichtig, mehr Werkzeuge zur Verfügung zu stellen, um solchen Bedenken entgegenzuwirken, sowohl aus PR- als auch aus gesundheitlicher Sicht.

Facebook investiert viel in diese Arbeit und ist ständig auf der Suche nach Verbesserungen – dies ist keine reflexartige Reaktion auf diese neuen Bedenken. Da der Druck jedoch zunimmt, wird das Unternehmen aufgefordert werden, noch mehr Tools wie dieses bereitzustellen und Einblicke in die tatsächlichen Auswirkungen solcher Bemühungen auf die Nutzung der Plattform zu geben.

Quelle: SocialMediaToday

Keine Kommentare vorhanden