Linkbuilding 2024

1. Was ist Linkbuilding und warum ist er relevant für SEO?Ein wesentlicher Teil der Offpage-Optimierungen einer Webseite wird durch das Linkbuilding (auch Backlinkaufbau) eingenommen, also durch das aktive Bemühen um Gewinnung von Backlinks und Linkpartnern. Nach der Aussage von...

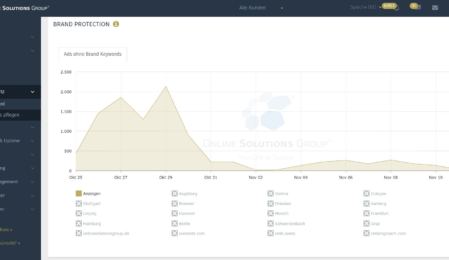

Brand Monitoring 2024

In den letzten Jahren kam es zu einzelnen gerichtlichen Urteilen, die die Verwendung fremder Marken in der bezahlten Suche verändert hat. Das hat dazu geführt, dass Brand Monitoring und die ständige Überwachung von Markenschutz-Verletzungen immer wichtiger wurde. Händisch ist...

OpenAI stellt GPT-4o mini vor

OpenAI hat GPT-4o mini vorgestellt, ein neues Modell, das nicht nur kostengünstiger, sondern auch leistungsfähiger und schneller ist als sein Vorgänger, GPT-3.5 Turbo. Dieses neue Modell wird die Nutzung von Künstlicher Intelligenz in Unternehmen weiter vorantreiben und beeindruckende Vorteile...

Online-Marketing für Tiernahrung: SEO für Tierfutter in 2024

1. Branchenanalyse: Online-Marketing Lösungen für Tiernahrungsshops1.1 Warum Online-Marketing in der Tiernahrungsbranche wichtig istZwischen den Anbietern von Tiernahrung herrscht ein erbitterter Konkurrenzkampf. Die drei Marktführer hatten beispielsweise 2013 gemeinsam nur gerade einmal 40,8 Prozent Marktanteil. Die verbleibenden 59,2 Prozent teilten...

Affiliate Marketing 2024: Was ist es und wie funktioniert es?

Im Onlinemarketing spielt Affiliate Marketing eine wesentliche Rolle und gehört gewissermaßen zu den klassischen Disziplinen. Einfach gesagt: Der Begriff Affiliate oder auch Affiliate Marketing stammt aus den USA und entspricht in etwa der deutschen Übersetzung Partnerprogramm. Angefangen hat alles 1997. In...

Online-Marketing für Tiernahrung: SEO für Tierfutter in 2024

1. Branchenanalyse: Online-Marketing Lösungen für Tiernahrungsshops1.1 Warum Online-Marketing in der Tiernahrungsbranche wichtig istZwischen den Anbietern von Tiernahrung herrscht ein erbitterter Konkurrenzkampf. Die drei Marktführer hatten beispielsweise 2013 gemeinsam nur gerade einmal 40,8 Prozent Marktanteil. Die verbleibenden 59,2 Prozent teilten...

Bilder SEO: Leitfaden 2024 für erfolgreiche Bildoptimierung

Das Auge isst mit, heißt es in der Gastronomie. Doch nicht nur Speisen müssen appetitlich präsentiert werden, das Gleiche gilt auch für Webtexte. Damit Ihre Webseiten nicht zu einer Bleiwüste erstarren und potenzielle Besucher abschrecken, sind hochauflösende, ansprechende Bilder im...

B2B – Der große B2B SEO Guide 2024

1. EinleitungSuchmaschinenoptimierung (SEO) gehört nach wie vor zu einem der wichtigsten Kanäle für B2B-Marketing. Auch im B2B Geschäft suchen User bei Google nach Produkten und Dienstleistungen. Folgende Studien zeigen, wie wichtig SEO für B2B-Anbieter ist:Rund 64 % der Marketer...

Wichtigste SEO-Tipps im Bereich Technik 2024

Von Ladezeiten über Cloaking bis hin zum HTML-Code: Wir geben Ihnen die wichtigsten Tipps für eine SEO Technik.Leitfaden für SEO-optimierte EntwicklungUnsere Tipps zu den verschiedenen Optimierungsbereichen sollen Sie in die Lage versetzen, schwerwiegende SEO-Fehler bereits im Vorfeld zu erkennen...

SEO Day 2022: Die Highlights und besten SEO-Tipps

Am 08.11. war es in Köln wieder soweit: Am SEO Day 2022 versammelte sich die SEO-Community für ein Come-together mit spannenden Vorträgen und einem Rückblick auf das SEO-Jahr 2022. Im Hyatt Regency Cologne gaben die namhaften Speaker wertvolle Insights...